大模型时代,AI算力芯片难题如何“破局”?| 原创

大模型时代,AI算力芯片难题如何“破局”?| 原创

2023-12-15 09:29:08 来源: 抢沙发

抢沙发

2023-12-15 09:29:08 来源:

摘要:据麦肯锡最新关于AI现状的全球报告显示,生成式AI工具的爆炸式增长趋势已正式到来,其中大模型则是生成式AI展现其革命性潜力的代表,引领着下一场科技变革。随着“千模大战”的到来,算力需求迎来了大爆发的同时,芯片产业也面临着巨大的机遇与挑战。

关键词:

AI

算力

大模型

原创专栏

据麦肯锡最新关于AI现状的全球报告显示,生成式AI工具的爆炸式增长趋势已正式到来,其中大模型则是生成式AI展现其革命性潜力的代表,引领着下一场科技变革。随着“千模大战”的到来,算力需求迎来了大爆发的同时,芯片产业也面临着巨大的机遇与挑战。

(图源:morningexpress)

AI大模型浪潮下,算力需求大爆发

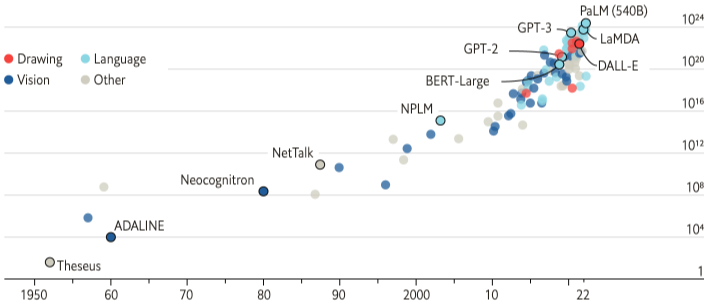

ChatGPT 引领的AI大模型大潮下,科技巨头及大批新兴企业争先涌入大模型赛道。随着模型的增加,生成性AI应用的算力需求也呈现指数级增长。

(图源:research.aimultiple)

据科技部新一代人工智能发展研究中心发布的《中国人工智能大模型地图研究报告》显示,截至今年5月份,我国10亿参数规模以上的大模型已发布79个,8月份该数据已超过110个,国内研发的大模型数量排名全球第二。大模型的火热发展,让相对应的AI算力也面临了严峻的挑战。

过去的十年里,AI的每一点突破都清晰可见,这也是由于其对指数级增长的计算能力需求驱动的结果。比如,在2020年发布一个AI大模型,会比2012年首次普及AI深度学习模型时多用600,000倍的计算能力。OpenAI的研究人员早在2018年就强调了这一趋势,并试图量化增长的速度,但现在很明显,这种增长速度已经不能长期维持了。

因为,AI大模型所需的算力,似乎有了“瓶颈”期。

当前,很多大模型的参数量已经超过了万亿规模,模型参数量的进一步增加,让GPU算力也随之成倍增加。这就意味着,需要更大规模的算力平台,才能进行如此规模大模型的训练。

而近日,谷歌原生多模态大模型Gemini“霸榜”热搜,彻底“点燃”了一场关于AI的算力竞赛。

支撑AI大模型的基石:算力网络

持续“狂飙”的AI大模型发展催生了更多新场景,海量数据处理、实时信息交互等需求的提升,都对算力提出了挑战。

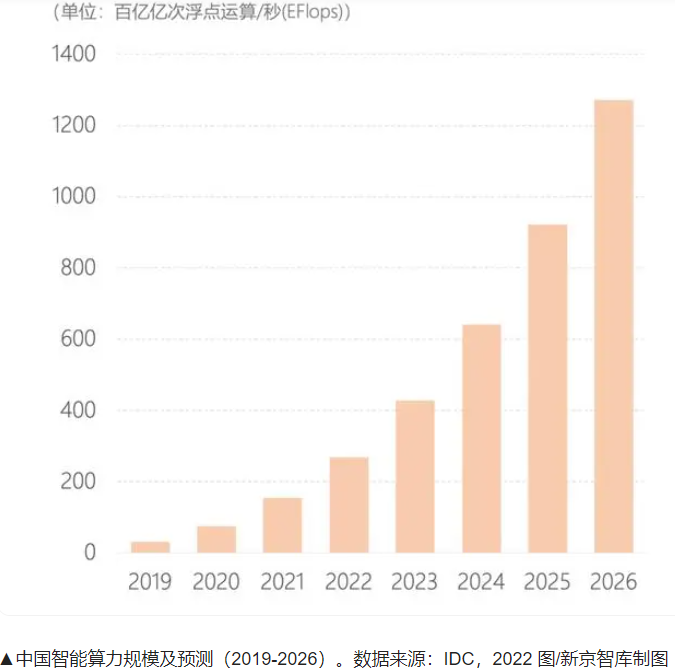

据了解,目前算力分为通用算力(基础算力)、智能算力和超算算力三大板块,分别应用于基础通用计算、AI训练和推理计算以及尖端科学领域的计算。据工信部数据显示,截至2022年底,中国的算力总规模已达到180EFlpos,存储总规模超1000EB。据信通院相关研究估算 ,在全球算力规模中,中国已与美国并驾齐驱,分别占据了33%和34%的市场份额。

最新发布的《中国人工智能计算力发展评估报告》也显示,2023年我国人工智能算力市场规模将达到664亿元,同比增长82.5%,人工智能算力需求快速增长。

(图源:IDC)

算力需求大爆发,算力网络则正是支撑AI大模型的重要基石。

随着算力需求市场持续壮大,有算无网,就会变为算力“孤岛”。算力网络的构建则可以有效帮助解决“算力孤岛”问题,并有助于加快推进数字时代经济发展。然而,目前业界在算力网络构建方面也面临着不少挑战,比如数据流通以及算力共享。

算力网络主要围绕算力共享建设一整套算力生态链,其中包括算力生产、算力聚合、算力赋能、算力调度、算力供应等环节,而链中每一个环节,都有各自面临的问题。此外,算力网络的建设和运营也需要通过长期探索来逐步完善。

作为一种复杂的技术网络体系,算力网络涉及多学科、多领域的融合,目前其融合深度、广度还不足,算力资源的整合优化、高效调度与协同处理等问题,以及能源和资源分布不均衡、算力和网络设备交互接口、信令协议等标准尚不统一等挑战都需要面对且待解决。

算力“角逐”战场:芯片难题何解?

算力需求的大爆发,让作为支撑AI大模型的基石、算力的核心——AI算力芯片短缺等困境也“浮出了水面”,且亟需“破局”。

(图源:InfoWorld)

早在今年7、8月份的时候,有关GPU短缺的讨论就已在社交媒体疯传,AI大模型时代的算力芯片已成业界“群雄角逐”的焦点。

由于通用芯片(如CPU)已无法支持高度并行化的AI深度学习模型,因此支持并行计算能力,且具备大算力、高互联、强扩展优势的AI算力芯片需求日益增加,且这一趋势还将继续。

目前而言,即使是拥有众多世界级工程师和强大研究背景的Intel,也需要3年的工作来开发自己的AI芯片。因此,对于大多数大模型公司来说,从云GPU提供商租用容量几乎成了开发AI大模型的主要方式。

其实一直以来,科技巨头们始终在自研芯片方面不断超越。现在,业界将目光聚焦在AI超算芯片上,为2023年全球算力市场带来了新变化。为了解决算力芯片的问题,众多AI芯片公司纷纷推出新型态AI加速芯片,为AI算力芯片多元化发展提供了基础“土壤”。

12月7日,全球知名芯片巨头AMD在“Advancing AI”大会上正式发布了Instinct MI300X与MI300A两款旗舰级AI加速芯片产品,并将此前做出的2027年1500亿美元的AI芯片市场预期,大幅上调到4000亿美元,给国内AI芯片厂商带来信心加持。目前,微软、Oracle、Meta等厂商均表示将支持MI300X芯片,微软更是表示将评估对AMD的新AI加速器的需求。

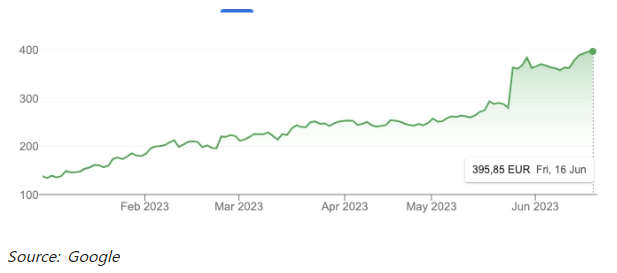

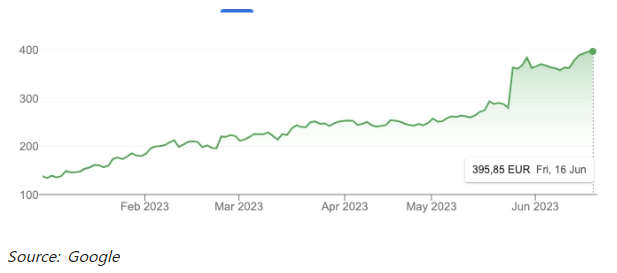

据research.aimultiple数据显示,由于生成式AI的繁荣,同样是全球芯片巨头的英伟达也在2023年第二季度取得了出色的业绩,估值达到了1万亿美元,巩固了其作为GPU和AI硬件市场领导者的地位。

(图源:research.aimultiple)

对于AI算力芯片来说,在可编程性和性能功耗这两个矛盾因素间找到平衡,芯片才能真正应用。对此,我国其实一直在追赶,且目前也已经取得了成果。

比如,去年上海交通大学先进体系结构实验室团队去年就已经借助开源,推出了第一代开放开源通用GPU芯片平台“青花瓷”,意在降低软件瓶颈、打造开放的软件生态,帮助芯片厂商极大地节省软件花销,为构建开源算力芯片生态提供助力。

写在最后:

AI大模型作为一种生成式AI的代表,正在各个领域展现出强大的应用潜力。生成式AI大模型持续带来惊喜和突破的同时,算力芯片方面也在持续发力,为“大算力”时代下AI大模型的不断落地应用赋能,让人们早日看到科技变革的曙光。

编辑 | MissD

·END·

第四十届CIO班招生

国际CIO认证培训

首席数据官(CDO)认证培训

责编:zhanghy

免责声明:本网站(http://www.ciotimes.com/)内容主要来自原创、合作媒体供稿和第三方投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

本网站刊载的所有内容(包括但不仅限文字、图片、LOGO、音频、视频、软件、程序等)版权归原作者所有。任何单位或个人认为本网站中的内容可能涉嫌侵犯其知识产权或存在不实内容时,请及时通知本站,予以删除。