最近,谷歌的AI研究人员、 "Test of Time Award"得主Ali Rahimi指出,计算机通过尝试错误法(trial and error)进行学习的机器学习算法已经成为“炼金术”的一种形式。Rahimi说,如果不深入了解构建和训练新算法所需的基本工具,研究人员就会像中世纪的炼金术士一样用道听途说的方法来研究人工智能。

去年在NIPS会议上,谷歌的AI研究人员、 "Test of Time Award"得主Ali Rahimi(阿里·拉希米)对他所在的研究领域进行了一次猛烈的抨击。

Rahimi在NIPS现场的演讲中指出,计算机通过尝试错误法(trial and error)进行学习的机器学习算法已经成为“炼金术”的一种形式。他说,研究人员不知道为什么某些算法有效,而其他算法不起作用,在选择AI架构方面也没有严格的标准。

最近,在ICLR 2018发表的一篇论文中,Rahimi和几位合作者列举了他们认为是炼金术问题的一些案例,并为提高AI的严谨性提出了一些处方。

“这个领域存在一种’痛苦’,”Rahimi说,“我们中许多人感觉自己使用的是一种外星技术。”

在解释 “炼金术” 时,Rahimi 说道:“吴恩达说过,机器学习就是新时代的电力。我却认为机器学习慢慢变成了新时代的炼金术。炼金术本身并不是坏事。它推动了冶金、纺织、化工、医疗等技术的发展,但是同时炼金术师也相信真的能把铜片变成黄金。 我希望我所生活的世界是基于非常稳固、有规律、有系统理论的知识体系上,而不是炼金术上。”

炼金术问题与AI的可重复性问题不同。可重复性问题是指,由于实验和发表的不一致,研究人员无法复制彼此的结果。

炼金术问题也与机器学习的“黑箱”问题或“可解释性”问题不同,后者是指难以解释特定的AI如何得出其结论。

正如Rahimi所言,炼金术问题和黑箱问题的区别在于,“一个机器学习系统是黑箱”和“整个领域变成了黑箱”。

Rahimi说,如果不深入了解构建和训练新算法所需的基本工具,研究人员就会像中世纪的炼金术士一样用道听途说的方法来研究人工智能。

谷歌的计算机科学家Francois Chollet补充说:“人们受草包族科学吸引,”依靠“民间传说和魔法咒语”。例如,他说,研究人员倾向于采用一些小技巧来调整他们的AI的“学习率”—— 算法在每次错误后自行纠错的比率——而不理解为什么某个算法比其他的更好。

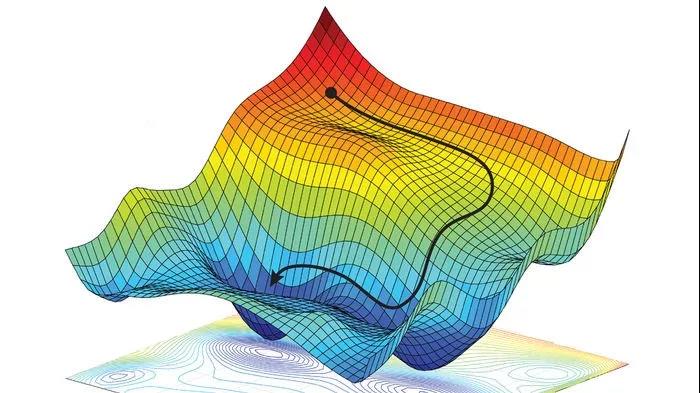

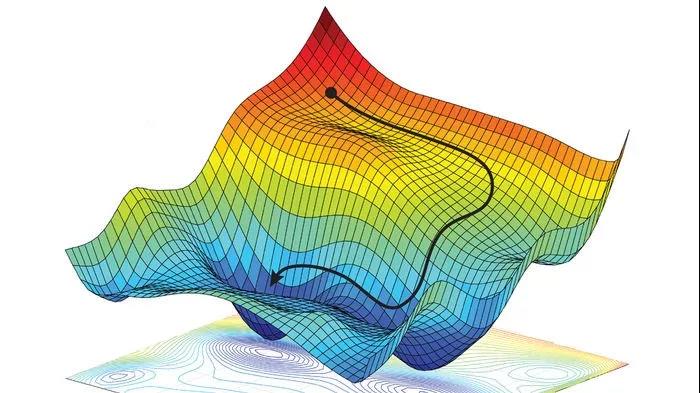

另一些情况下,研究人员像在黑暗中乱撞一样训练他们的算法。例如,他们实现了所谓的“随机梯度下降”,以优化算法的参数,获得尽可能低的失败率。然而,尽管有数千篇关于随机梯度下降的学术论文,以及无数应用该方法的技巧,这个过程仍然依赖于试错。

随机梯度下降使用尝试错误法来优化算法,目标是找到3D景观中的最小值

Rahimi的论文强调了可能导致的浪费精力和次优性能。例如,论文指出,当其他研究人员对一个state-of-the-art的语言翻译算法去除了大部分的复杂性时,它实际上在将英语翻译成德语或法语时的表现更好了,这表明算法的原作者并没有完全理解这些额外的部分有什么好处。

反过来,Twitter的一名机器学习研究人员Ferenc Huszar说,有时候,附加在算法上的花里胡哨的那些东西是这个算法唯一好的部分。他说,在某些情况下,算法的核心部分在技术上是有缺陷的,这意味着它的好结果“完全归功于应用的其他技巧”。

至于机器学习中哪些算法、什么时候表现最好,Rahimi提出了一些建议。他说,对于初学者来说,研究人员应该像翻译算法那样进行“消融研究”:一次删除算法的一个部分,以查看每个组件的功能。他呼吁进行“切片分析”,在此基础上,对算法的性能进行详细分析,以了解某些地方的改进会怎样在其他方面产生损失。

Rahimi还说,研究人员应该对他们的算法进行多种不同条件和设置的测试,并报告所有设置下算法的性能。

加州大学伯克利分校(UC Berkeley)的计算机科学家Ben Recht是拉希米有关炼金术演讲的共同作者,他提出,AI需要借鉴物理学的方法。在物理学中,研究人员经常把问题缩小到一个更小的“玩具问题”(toy problem)。“物理学家很擅长设计简单的实验来找到对现象的解释。”他说。

一些AI研究人员已经开始采用这种方法,例如,在测试图像识别算法时,先在小的黑白手写字符上实验,而非直接处理大幅的彩色照片,以更好地理解算法的内部机制。

DeepMind的计算机科学家Csaba Szepesvari认为,这个领域还需要减少对竞争性测试的重视。他说,目前,如果报告的算法优于某些基准,那么论文更有可能得到发表,而不是论文揭示了该软件的内部工作原理更容易发表。

这就是那些花里胡哨的翻译算法能够通过同行评审的方式。“科学的目的是产生知识,”Szepesvari说,“你要生产出别人可以采用、可以成为研究的基石的东西。”

但并不是每个人都同意Rahimi和Recht的批评。Facebook的首席人工智能科学家Yann LeCun担心,将过多的精力从研究前沿技术转移到核心的理解上可能会减缓创新的速度,阻碍AI的实际应用。“这不是炼金术,而是工程学。”LeCun说,“工程就是乱糟糟的。”

Recht认为有条不紊的研究和大胆开拓的研究可以达到一个平衡。“我们两者都需要,”他说,“我们需要了解哪些地方出现故障,以构建可靠的系统;我们也必须推进研究的前沿,以实现更多令人赞叹的系统。”

第三十五届CIO班招生

国际CIO认证培训

首席数据官(CDO)认证培训

责编:zhangxuefeng

免责声明:本网站(http://www.ciotimes.com/)内容主要来自原创、合作媒体供稿和第三方投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

本网站刊载的所有内容(包括但不仅限文字、图片、LOGO、音频、视频、软件、程序等)版权归原作者所有。任何单位或个人认为本网站中的内容可能涉嫌侵犯其知识产权或存在不实内容时,请及时通知本站,予以删除。