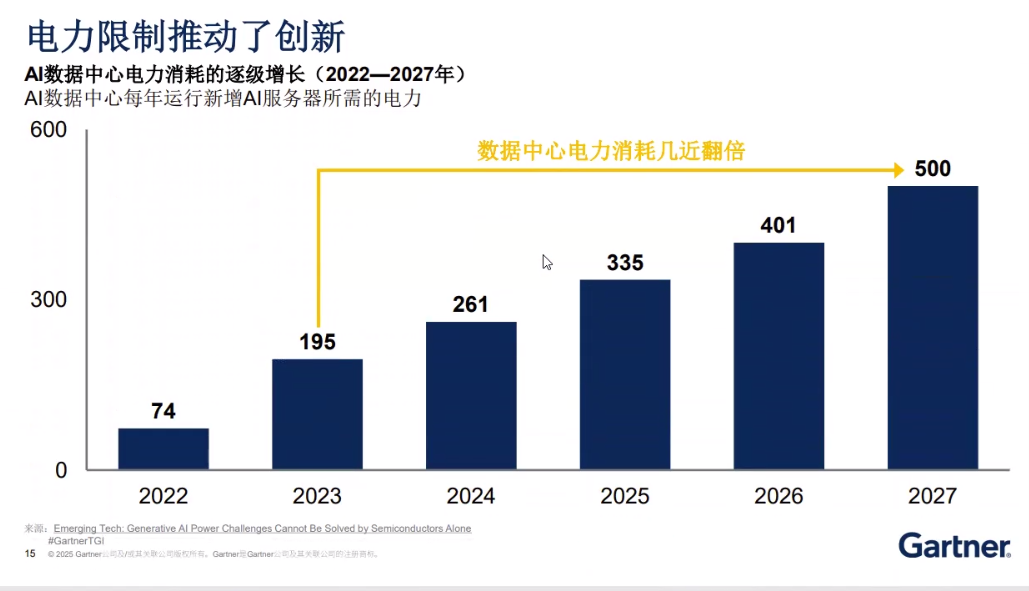

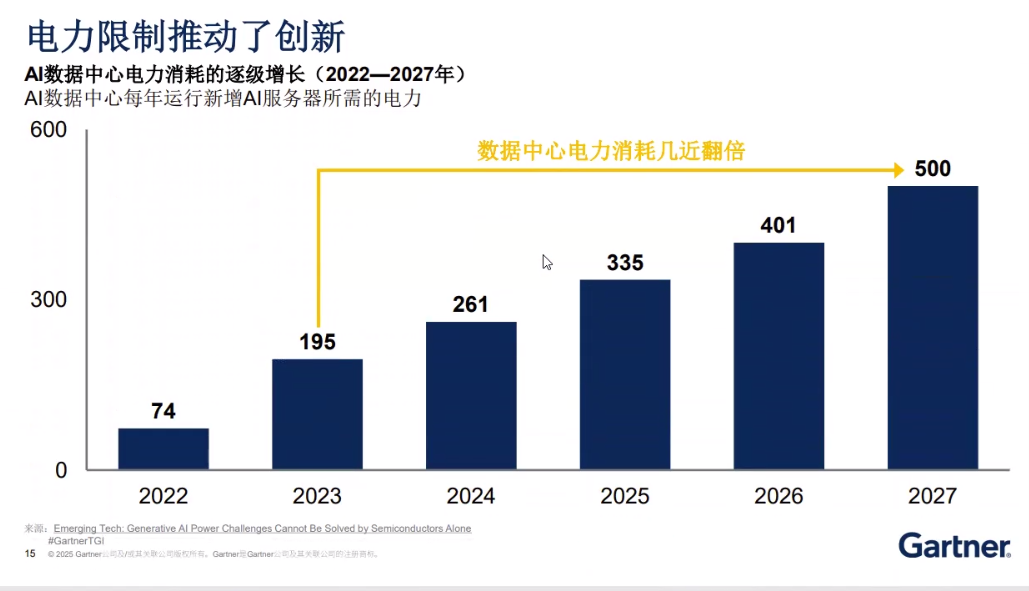

AI给企业业务带来颠覆的最可怕之处,是它会在半年内将许多不可能变为可能。但在带来许多神奇转变的同时,AI自身的发展却正在陷入一场危机,这就是电力短缺。2027年,全球因AI所带来的新增电力消耗,可能达到500兆瓦,这相当于是整个德国所消耗的用电量。并且这样的增长趋势还会一直持续下去,因此如何扼制这种趋势,避免AI发展走入死胡同,成了一个全球性的问题。而这个问题的答案,正藏在AI生态建设之中,或者换句话说,AI引发的电力短缺,正在引领整个AI产业界走上一条全新的道路。

电力短缺的成因

AI引发电力短缺并不是一个全新的课题,但在Gartner高级研究总监曾劭清看来,电力短缺因为AI的发展,正在呈现出一些全新的状态。

Gartner高级研究总监曾劭清

自2022年ChatGPT横空出世以来,整个行业掀起一波AI应用浪潮。Gartner预测,这波浪潮将在2027年导致AI计算性能翻倍。这不仅需要更多算力支持,还引得AI硬件厂商提升了算力密度,从而需要更多的电力去冷却处理器增加所产生的热量。这种绝对增量使得未来40%左右的数据中心会因为电力供应问题而受到限制。

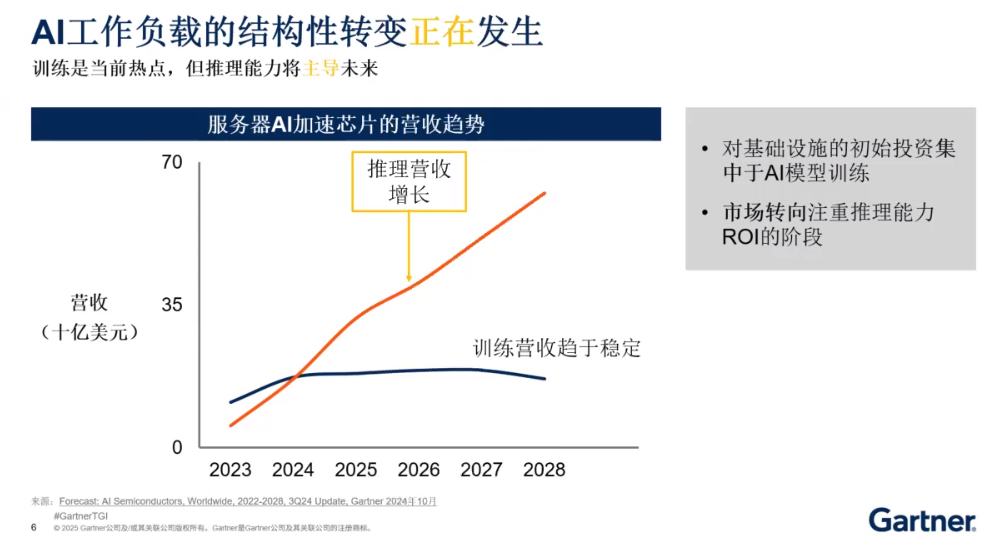

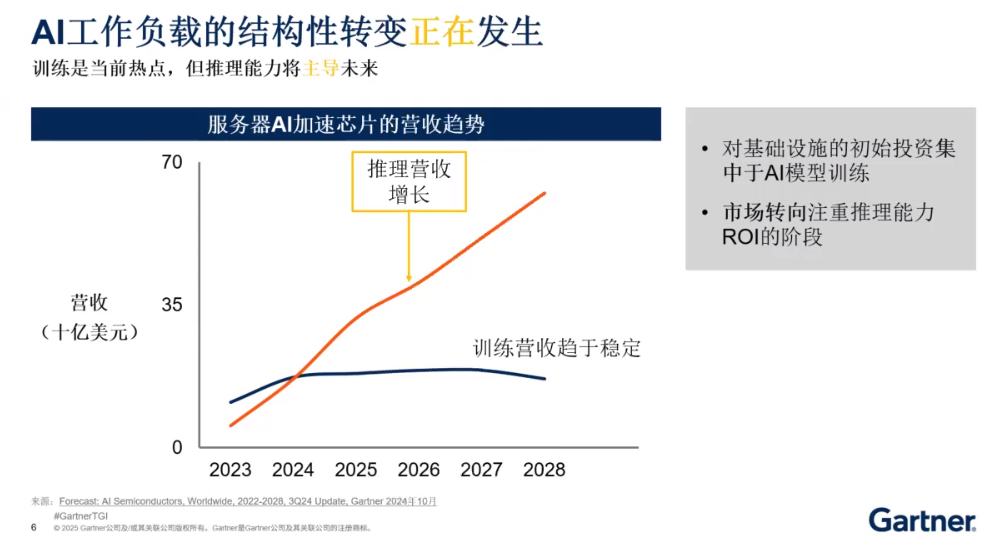

这种情况何时会出现,取决于AI技术的发展。当前流行的大模型绝大多数采用了Transformer架构,历经多年的训练之后,Gartner预测在2024-2027年,训练算力不会继续快速上升,而只是处于少量上涨的状态。但另一方面,当AI应用走入千行百业的企业之后,推理算力却引发了另一轮算力增长高潮。Gartner预测2028年推理算力与训练算力的比重,会达到“3:1”的状态。而这种情况在中国国内,还可能达到“4:1”的状态。

此前,英伟达和AMD的GPU属于通用处理器,英伟达占据了全球84%的市场份额,AMD也达到了6%的市场份额,这二者加在一起,就以90%的份额成为AI处理器的绝对王者。另一方面,后来者却另辟蹊径,采用“加速器”的策略,根据上层模型的算法去定制算力,包括华为910、海光、寒武纪等都是在走AI加速器这条路。

这二者各有优缺点,采用“加速器”型处理器去支持AI训练,能力就欠缺了很多。而采用GPU去做AI推理,存在一个大问题,就是利用率的问题。目前GPU的应用率在70%左右就已经达到顶鼎峰了。一些企业的利用率甚至长期在“150%-320%”之间徘徊,要提升利用率就需要用到工程化能力。

在模型层面,变化同样也在发生着。利用文字生成图像或视频类的DisfusionDiffusion模型正在变得越来越流行,这也将导致基于DisfusionDiffusion模型工作的加速器芯片会增长25倍。从这一个侧面,我们可以看出通用架构GPU正在往算法适配型的芯片转移。

这一切变化都会增加算力需求的增长速度,相应地也就会需要更高的电力供应量。电力和成本必将在某一天成为AI发展的拦路虎。

电力短缺里的新机会

众多业界专家认为,AI应用相比于此前云计算、移动技术、区块链等技术,会为企业业务带来更多的创新。当企业业务价值被重构之后,想让AI应用落地的速度慢下来,是一件不可能的事情。这样,唯一可行的办法,就是搬开电力短缺这只拦路虎。

当前,从电力成本来看,企业每在AI服务器上投入一美元,其中电力消耗就要占到0.35美元。如此之高的成本,曾劭清认为,光靠半导体厂商努力是不够的,电力短缺里的新机会,恰恰在于会引导半导体厂商、软件厂商在内的整个AI生态,通过创新产生全新的变化。

具体说来,曾劭清表示:“通过适配软件,算力的利用率是完全可以提高的。原因很简单,算力领域存在许多个瓶颈。首先是CPU与GPU通讯的瓶颈,其次是高带宽内存在GPU上没有完全达到共享。内存瓶颈的实质就是需要更多GPU,而如果把这些内存打通形成一个可共享的资源池通讯的库,就可以节省新增GPU的需求。最后是网络瓶颈,提升GPU与GPU的互联、以及AI服务器与AI服务器的互联能力,消除网络拥堵和丢包,就可以因为提升GPU之间的数据通讯能力而降低GPU的需求数量。”

在硬件方面,通过提升工程能力,同样存在着降低算力需求的空间。曾劭清介绍说:“算力的提升必然带来对制冷能力需求的提升,这时就存在一个算力与制冷能力的匹配问题。如果可以实现对于基础设施的分析,判断出高强度加速计算所需要的制冷量,就可以调动空调增加相应的制冷量给相关的高强度计算机柜,同时还可以减少没有进行高强度计算或闲置机柜的制冷量,也就是把冷能量送到它需要去的地方,空调电力就可能节省下来。”

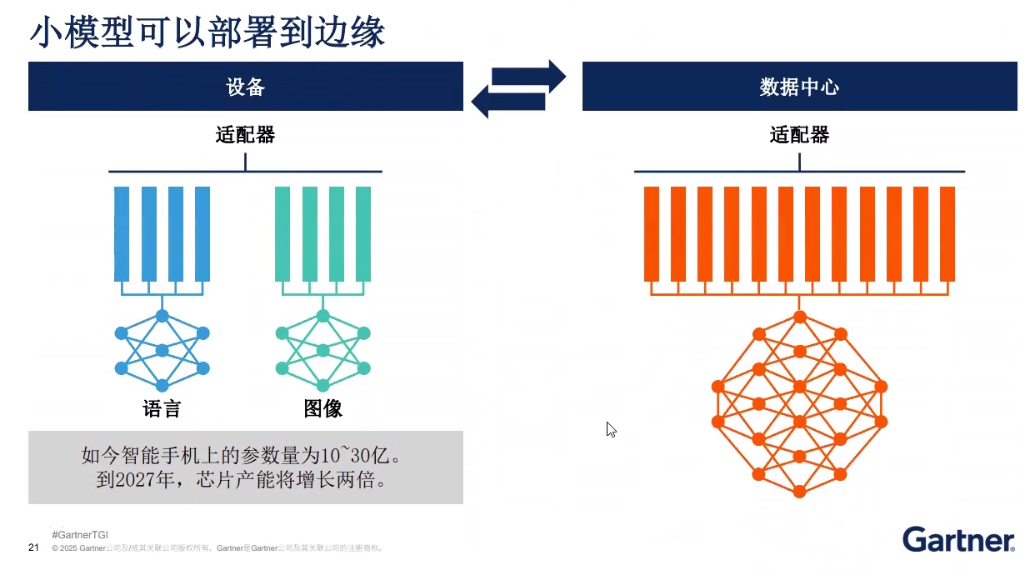

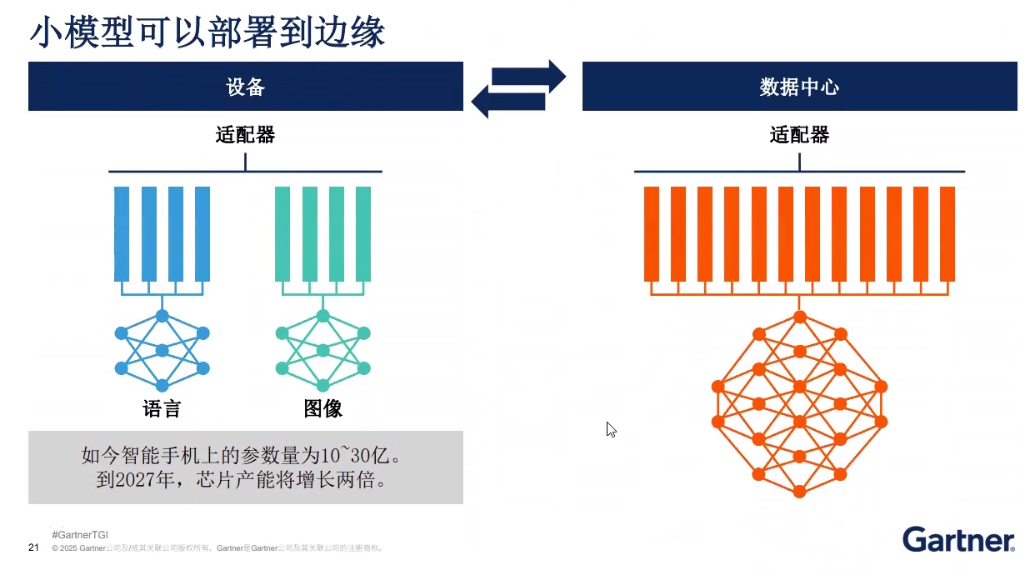

最后,在模型层面,同样存在着优化的可能性。曾劭清解释道:“事实上,企业AI应用中很多时候并不需要大模型,而是需要个性化、兼顾隐私与安全、减少延时、有着更经济的成本和电力的小模型。如果采用大模型,同时也就意味着需要更多的GPU和AI加速卡,也就意味着电力消耗的增多。所以在企业进行AI战略规划时,就要考虑是不是真正需要用到DeepSeek满血版这样的大模型,是不是一个“千问”更经济、更精准,具有不同参数量供选择的模型。企业在进行AI规划时,就必须做精打细算的规划,在软件和模型选择、模型参数、数据量上,以及数据量与服务场景的关联度方面,进行更多考量。进而据此优化AI基础设施和电力需求。”

曾劭清强调:“其实许多小模型可以部署到边缘端,比如文生图场景,就可以部署到边缘去。如果部署到运营商层,就可能要经过城域网传输,带宽费用可能就会更高。反过来,当不需要大模型时,小模型部署到边缘,则会经济得多。”

生态重构进行时

从用户的角度来看,Gartner的调研数字表明,60%的企业的AI应用与场景都在AI实验阶段被淘汰,而不能最终部署到生产环境。并不匹配。从这个角度来看,60%企业的AI应用场景选择在规划阶段都是落地实际上是不成功的。AI迅猛发展引发的电力短缺问题,将迫使整个AI生态都不得不被动做出调整。这个生态既包括半导体厂商,也包括相关的软件厂商、模型服务提供商,还包括了IT服务服力咨询商和用户。

从咨询商的角度来看,用户在落地AI应用之前,需要的整体规划,当这种能力不足时,就需要引入第三方咨询机构,制定中长期规划。作做为传统企业的CIO,也必须注重提升这方面的认识。

对于基础设施厂商来说,边缘AI的性能超过云AI,这将是一个不争的事实。 从以往云计算的发展规律来看,边缘跟云之间是一个相对关系,但更是云的一个组成部分。IT基础设施厂商就既要看到推理型性基础设施将大量增长的趋势,还必须尽可能多地把AI加速器的需求部署到各个边缘域里面去。

而对于软件厂商来说,同样需要适应AI引发的新趋势。以智能体应用来说,有数字显示96%的企业将实施智能体,而对于SaaS厂商而言,原来的收费方式是按用户数量来计量的。而如果十个用户共用一个智能体,就可能出现用户数量骤减,但用量却骤增的情况出现。这时,SaaS厂商就将被迫采用用量而非用户数量的传统计量方法来收费了。

从这些角度来看,AI应用的发展将引发包括软、硬件和咨询服务商在内的整体生态变化,用户的认识也将随着AI应用落地的深入而发生新变化。

影响IT生态发生变化的因素有多个,AI应用引发的电力短缺问题虽然看似是一个局部问题,却可能因此而引发蝴蝶效应,在总体上引发大的变化。而从用户层面来看,整个生态的优化将有利于他们提升AI应用落地的成功率。

第四十一届CIO班招生

国际CIO认证培训

首席数据官(CDO)认证培训

责编:lijj

免责声明:本网站(http://www.ciotimes.com/)内容主要来自原创、合作媒体供稿和第三方投稿,凡在本网站出现的信息,均仅供参考。本网站将尽力确保所提供信息的准确性及可靠性,但不保证有关资料的准确性及可靠性,读者在使用前请进一步核实,并对任何自主决定的行为负责。本网站对有关资料所引致的错误、不确或遗漏,概不负任何法律责任。

本网站刊载的所有内容(包括但不仅限文字、图片、LOGO、音频、视频、软件、程序等)版权归原作者所有。任何单位或个人认为本网站中的内容可能涉嫌侵犯其知识产权或存在不实内容时,请及时通知本站,予以删除。